‘Las máquinas aprenden’: Inteligencia Artificial evoluciona y puede usarse para engañar, pero no todo está perdido

El desarrollo de Inteligencia Artificial para la generación de imágenes y videos ha sido aprovechada por desinformadores para intentar alterar la realidad, pero la IA también se emplea en herramientas que nos permiten combatirla.

El avance tecnológico ha logrado poner al alcance de cualquier persona con acceso a internet herramientas de Inteligencia Artificial (IA) tan sofisticadas que son capaces de idear un nuevo negocio de emprendimiento, mejorar diagnósticos médicos y hasta mantener una conversación sobre el amor.

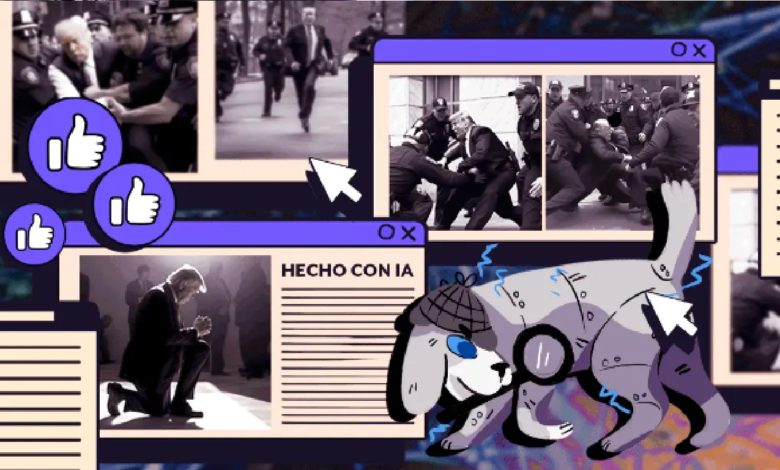

Pero: ¿qué pasa cuándo la IA puede crear imágenes tan realistas que parecen fotografías y pueden hacernos creer que son reales? Ya vimos ejemplos como el de las imágenes de Trump encarcelado o las del papa Francisco y un abrigo blanco con mucho ‘flow’.

Platicamos al respecto con Pablo Fernández, director ejecutivo y periodístico de Chequeado, y con Tomás Rudich, coordinador de verificación de bulos en Newtral, quienes nos contaron que, aunque la Inteligencia Artificial es un campo muy cambiante que sigue en desarrollo y que representa nuevos retos, aún hay herramientas para combatir la desinformación.

Y mejor aún: el aprendizaje y el ojo humano.

Desinformación con IA

En las últimas semanas, el equipo de Animal Político ha verificado al menos seis imágenes creadas con IA que fueron utilizadas para desinformar: primero nos quisieron hacer creer que existía una especie de Serpens Cattus o gato serpiente, también que el expresidente Donald Trump fue perseguido por la policía de New York, y que la fotografía del activista Julian Assange encarcelado y demacrado era real.

Alguien también uso una herramienta de IA para crear la imagen del papa Francisco portando tenis y una chamarra voluminosa, y otra del presidente Putin de rodillas frente al presidente de China.

Pero el uso de imágenes ficticias no es la única forma de desinformar con IA; también hemos detectado el uso de avatares con aspecto humano para intentar dar credibilidad a información engañosa sobre política, vender productos milagro para bajar de peso, y de paso para hacer campaña a favor de López Obrador y de Morena en redes sociales.

Estas desinformaciones tienen en común que se usó IA para generarlas, pero también para verificarlas. Empecemos por saber a qué nos referimos cuando hablamos de Inteligencia Artificial.

¿Qué es la Inteligencia Artificial?

La empresa Google lo define como “un campo de la ciencia relacionado con la creación de computadoras y máquinas que pueden razonar, aprender y actuar de una manera que normalmente requeriría inteligencia humana o que involucre datos cuya escala exceda lo que los humanos pueden analizar”.

En otras palabras, tecnología que con algoritmos y sistemas administra y procesa una gran cantidad de datos, con lo que pueden realizar tareas que antes solo concebíamos como una posibilidad humana.

Una de las técnicas que la IA emplea es el machine learning (ML), que se centra en la creación de sistemas que mejoran en función de los datos que consumen. Tal como lo hace ChatGPT cada vez que alguien mantiene una “conversación” con dicha aplicación.

Pero la aplicación de IA en las herramientas digitales no es algo tan nuevo como pensamos, por ejemplo, el buscador de Google o los programas de asistencia virtual como Alexa usan este tipo de tecnología.

Pero últimamente ha pasado de todo, como que el diario El Mundo utilizara IA para ilustrar su portada. Y para dar un ejemplo de la magnitud del tema, incluso Elon Musk y cientos de expertos pidieron pausar avances en Inteligencia Artificial. Aunque poco después el mismo Musk aseguró en una entrevista que buscará desarrollar TruthGPT, “una IA que busque la verdad absoluta e intente comprender la naturaleza del universo”.

Herramientas contra la desinformación generada con IA

Olga Papadopoulou, miembro del Grupo de Análisis, Verificación y Recuperación de Medios (MeVer) y directora general del proyecto de vera.ai, explicó en un seminario sobre tecnología de datos que la desinformación visual plantea mayores riesgos porque puede ser más persuasiva que el texto, llama más la atención, es más tentador compartirla, y además puede cruzar fácilmente las fronteras.

En este sentido, comenzaron a popularizarse los deepfake que son un video, una imagen o un audio creado con tecnología y que imita la apariencia y el sonido de una persona.

Hasta ahora ya hay varias aplicaciones que intentan ayudar a identificar este tipo de productos que crean confusión y desinformación.

Por ejemplo, la herramienta de detección de DeepFake. Evalúa la probabilidad de manipulaciones faciales falsas profundas en imágenes y videos. En el caso del video, la herramienta segmenta el video en tomas, detecta los rostros representados en cada toma y estima la probabilidad de manipulación facial falsa en cada rostro.

Hugging Face y Mayachitra son otras plataformas de acceso abierto que suelen indicar si alguna imagen se generó con IA.

Pero, a decir de Tomás Rudich, coordinador de verificación de bulos en Newtral, “hay que tomar con pinzas estas herramientas porque te indican una probabilidad pero no puedes estar 100% seguro; además, la IA va evolucionando”.

También existen otras herramientas que pueden ayudar a identificar desinformación visual.

El proyecto vera.ai, por ejemplo, colabora en el desarrollo aplicaciones para herramientas de verificación. Por ejemplo, el asistente de verificación de imágenes que resalta las áreas de una imagen que han sido manipuladas digitalmente.

WeVerify e InVID también tienen herramientas muy útiles para revisar si una imagen ha sido alterada digitalmente.

De hecho, Tomás Rudich destaca que las principales herramientas para combatir la desinformación generada con IA son las que ya conocemos como la búsqueda inversa de la imagen en Google para rastrear en dónde ha circulado, o encontrar marcas de agua y sellos que nos permitan llegar a la persona que ha generado esta imagen.

Si quieres saber más al respecto, en este video te contamos cómo usar las herramientas de búsqueda inversa.

El aprendizaje no para

Pablo Fernández, director ejecutivo y periodístico de Chequeado, señala que “quienes generan desinformación tienen muchos recursos y herramientas y nosotros no nos podemos quedar atrás, para no perder esa batalla”.

Así que invita a los verificadores a usar elementos de IA y seguir aprendiendo sobre nuevas herramientas y metodologías de verificación.

Pero no solo se trata de saber cómo identificarlas, sino también cómo pueden generarse. “Si logramos resolver esto y seguir en la vanguardia y actualizados en cómo se generan estas piezas de Inteligencia Artificial, va a seguir siendo súper interesante el trabajo de nosotros y de nuestro colegas porque va a ser vital para la gente”, señala Fernández.

“Eso no lo hacemos tanto con máquinas sino con nuestro ojo”, destaca. Además, advierte que si bien todavía se pueden encontrar errores que quizá cualquiera pueda ver, es muy probable que muy pronto la IA aprenda a evitarlos y sea más difícil verificar.

De hecho, advierte que esto ya ha pasado, como él mismo lo comprobó, cuando en diciembre pasado ChatGPT le arrojó respuestas incorrectas, pero el error se corrigió al mes siguiente.

Error en la matrix

Hasta ahora, Midjourney y otras aplicaciones de IA que son usadas para generar imágenes que desinforman tienen dificultades para generar manos y eso se ha convertido en una pieza clave de la verificación. Aunque eso podría cambiar muy pronto.

Uno de los problemas que supone la desinformación creada con IA es que es algo que se actualiza de manera constante, lo que hace más difícil su verificación.

“Es un campo que está muy en evolución y muy cambiante y hay determinadas cuestiones que pueden servir hoy y más adelante pueden no servir”, advierte Tomás Rudich.

“Era un elemento muy identificable pero ya ha evolucionado la IA y ya no salen tan mal los dedos como antes”, dice Rudich, quien de momento sugiere poner atención y buscar anomalías como rostros difuminados o proporciones anómalas.

Pablo Fernández coincide: “Esto es muy dinámico y esto puede cambiar mañana. Hoy las imágenes estáticas tienen errores grandes en las manos, a veces en los ojos. Pero justamente se basa en un aprendizaje, las máquinas aprenden y esto seguramente se solucionará pronto”.

“No hay una solución mágica, es una combinación de todo esto: observación atenta, tratar de rastrear el original, buscar marcas de agua, ponerse en contacto con quien las ha generado y comparar con imágenes reales”, señala el especialista en verificación de Newtral.

Rudich recuerda que si no tenemos seguridad de la veracidad de la imagen lo mejor es no compartirla. Consejo que aplica para cualquier imagen, aun si no se sospecha de haber sido generada con IA.

Herramientas de IA contra la desinformación

Pero la IA no solo genera desinformación, también herramientas para combatirla, y un ejemplo de ello es el Chequeabot del proyecto argentino de verificación Chequeado.

Desde 2016, el chequeabot funciona con Inteligencia Artificial de Machine Learning, según nos compartió Pablo Fernández. Esta herramienta ayuda a encontrar frases a verificar, por ejemplo, dentro de un discurso político muy largo.

Otra herramienta que usa Inteligencia Artificial y que es usada para combatir la desinformación es ClaimHunter, un desarrollo de los verificadores de Newtral.es en España. Tomás Rudich nos contó que ayuda a los verificadores a detectar afirmaciones verificables de políticos en Twitter.

También desarrollaron la herramienta Claim Check, que permite detectar cuando una afirmación que desinforma se repite de manera constante por los personajes políticos.

Fuente: Animal Politico